记录一下自己学习langchain的过程。首先是模型安装和部署。

1.安装conda 环境

这一步没啥好说的,首先登陆官网Download Now | Anaconda根据你的系统选择合适的本本,这里左边Distribution Installers是指图形界面安装程序,Miniconda Installers是命令行安装程序。根据自己习惯选就行。

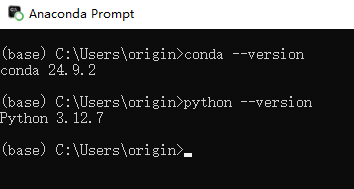

安装完成后会有一个anaconda的界面,输入conda --version和python --version检查版本,这俩都是安装时自带的 Python 版本,Base表示你处于默认的激活环境,一般来说我们不会在这个环境下操作,而是自己创建一个。

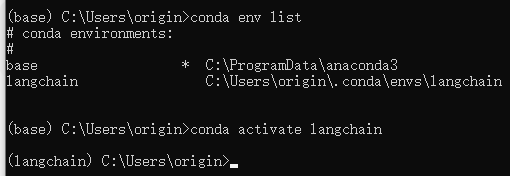

创建的环境的命令是conda create --name ml_env python=3.9,意思是创建名为ml_env的环境,使用Python 3.9;然后使用conda env list可以检查你拥有的环境,conda activate ml_env表示激活ml_env环境。

创建好了新环境,我们就激活它,然后在那个环境里解决大模型的部署问题。

2.ollama部署qwen

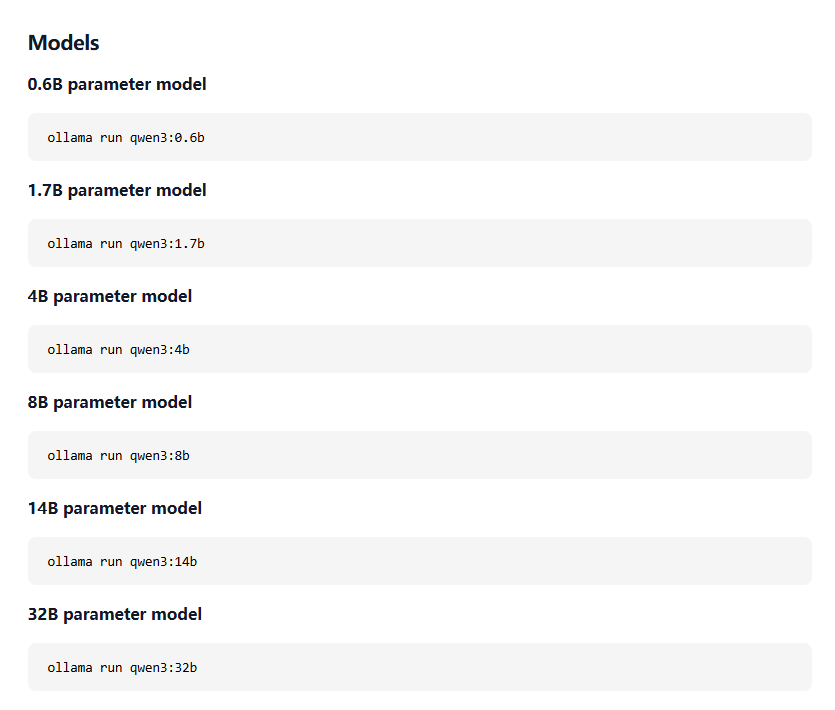

这里就直接跟着教程走吧,登录官网qwen3:8b,下载ollama,然后搜索你需要的模型,Qwen3会有一堆这样的模型和词条,你需要哪个版本就直接用那个版本下面的代码就行,首次运行他会自动给你下载:

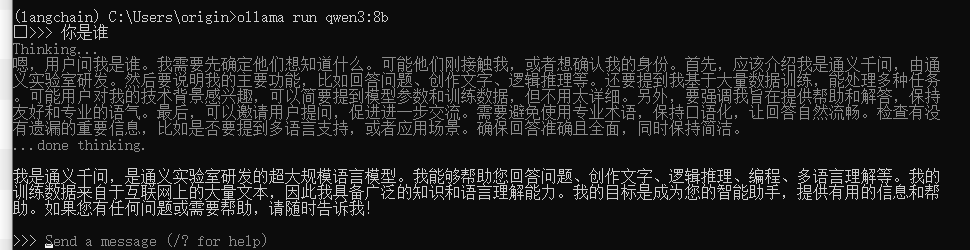

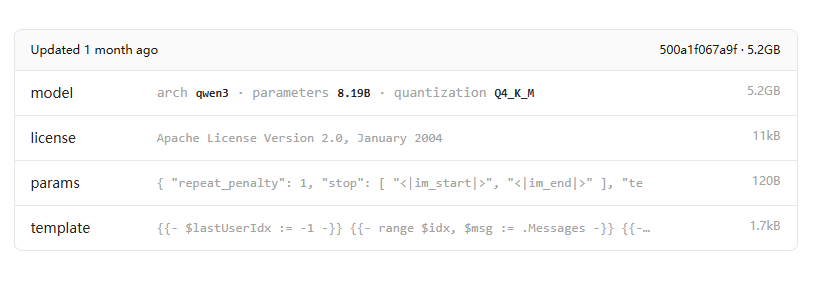

ollama run qwen3:8b这一步运行完后就能正常操作了。但这里需要注意一一点:ollama给你的模型基本都是量化后的,这是为了方便你本地运行:

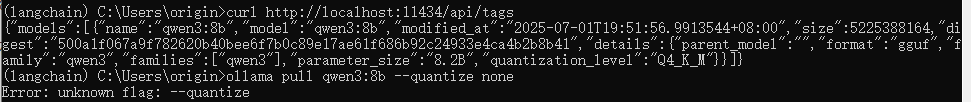

输入curl http://localhost:11434/api/tags代码,你也会看到"quantization_level":"Q4_K_M"},这证明我们下载的是个四位量化的模型,全量的模型应该是:quantize: none

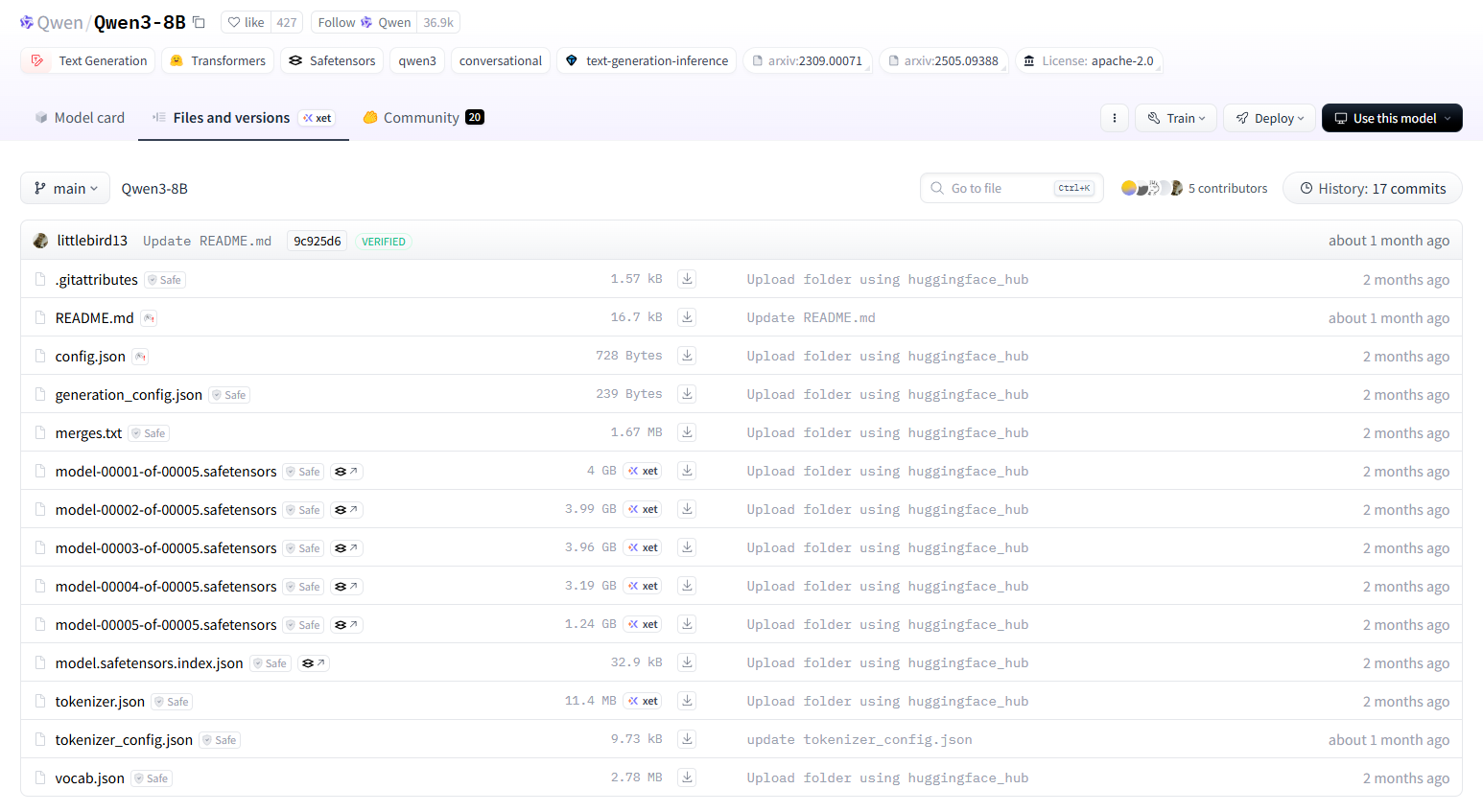

如果你要使用全量化的模型,那就需要到huggingface这种模型网站去他们Qwen (Qwen)的GGUF格式文件,而这个可就要大得多了:

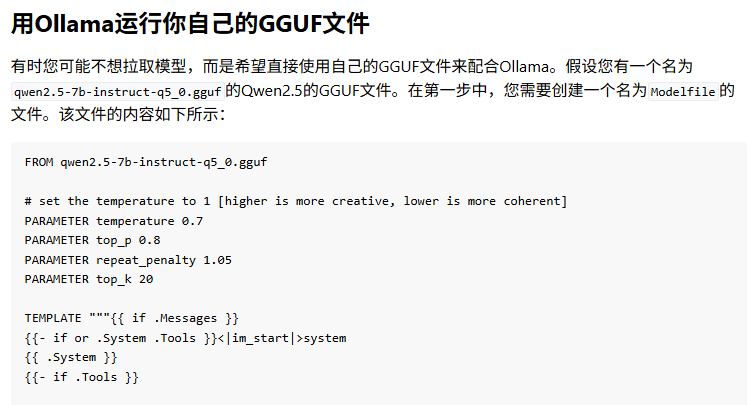

此外,你还需要根据Ollama - Qwen的流程创建文件:

然后这里我们说一下ollama调用API时的几个默认接口:

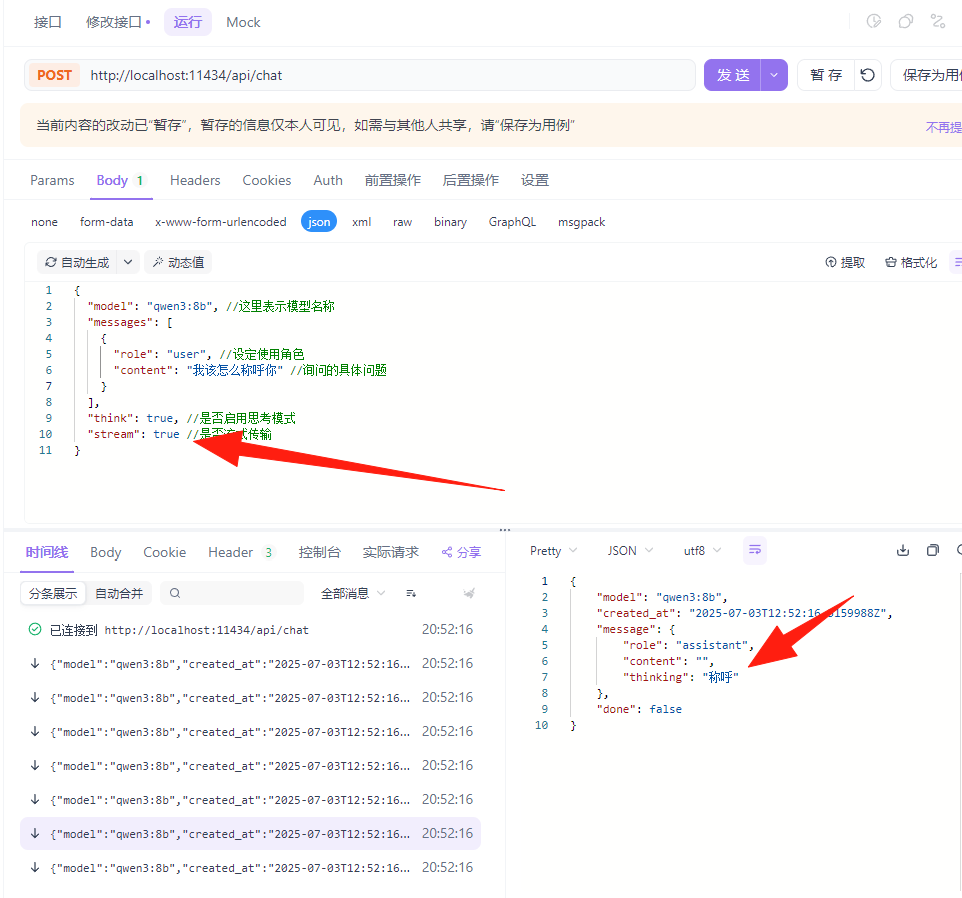

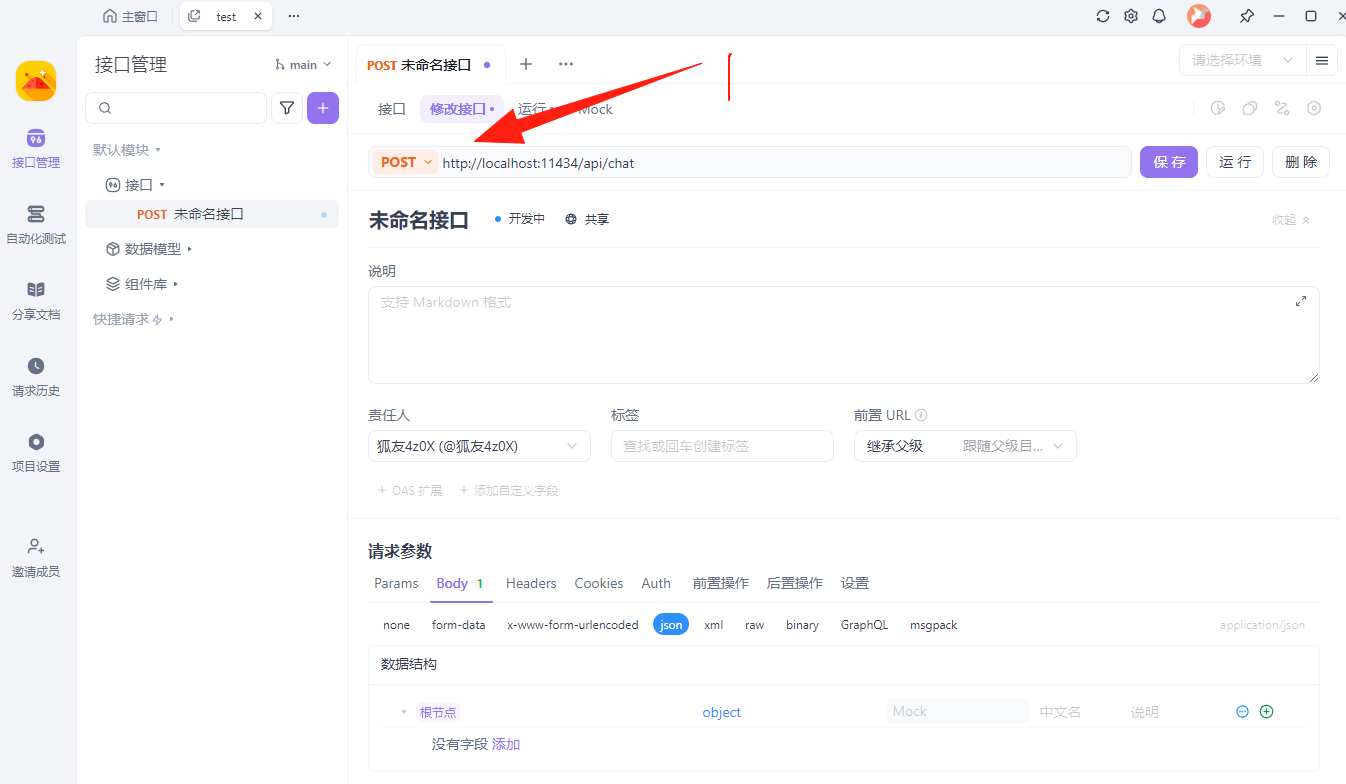

在本地部署时有个基础的:http://localhost:11434,然后根据你的需求,额外增加生成文本补全端点:POST /api/generate;对话式交互端点:POST /api/chat;我们这里首先点开1.新建接口,换成POST,并填写http://localhost:11434/api/chat

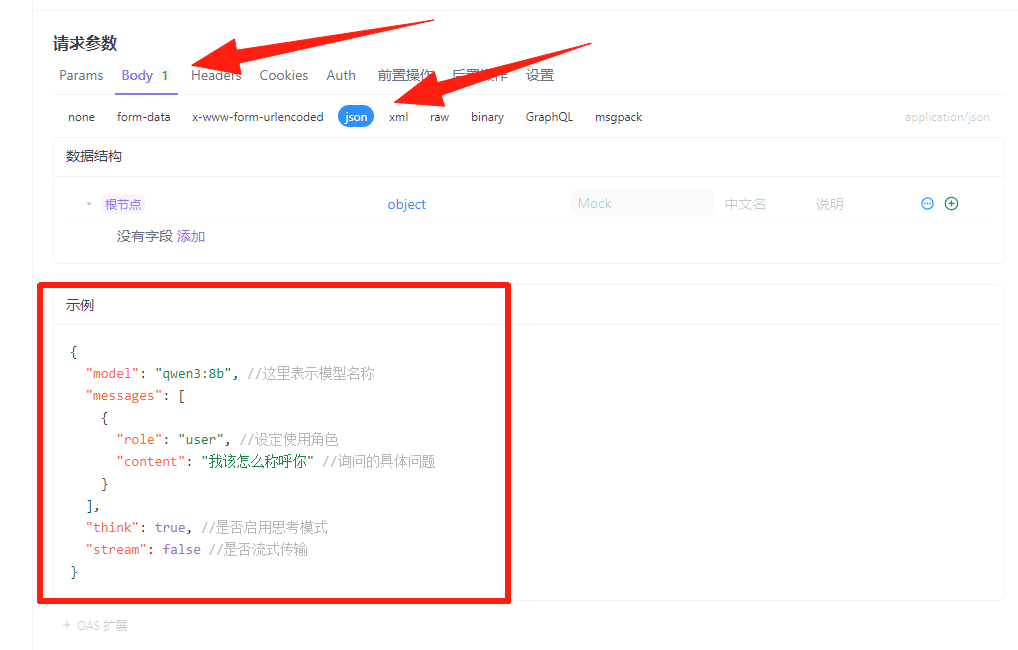

然后我们这里就点击Body,选择里面的json格式,并参考这样的格式添加一个示例。请注意,json格式不支持注释,我这里是为了方便理解和后续替换对应的块。

这里面的流式传输需要额外说明一下,流式传输是一种将数据分割成多个连续的小块(chunk)实时传输的方式,如果你选择了流式传输,那他就会一个字一个字(Token)的给你反馈: